Esta tecnologia polêmica pode realmente acabar com as guerras?

Entre promessas de paz e o risco de novos conflitos, a inteligência artificial surge como a ferramenta mais controversa do nosso tempo.

Basta uma busca rápida na internet para perceber que a relação entre “inteligência artificial” e “paz” é um campo de batalha de opiniões. De um lado, temos os mais céticos, que soam o alarme sobre a IA como uma possível ameaça existencial para todos nós. Do outro, visionários da tecnologia a veem como a chave para resolver alguns dos maiores problemas do mundo.

Imagine só poder usar a tecnologia para combater a solidão, frear as mudanças climáticas e até mesmo dar um fim a conflitos violentos que se arrastam por anos. Essa visão otimista ganhou uma força impressionante a partir de 2022, principalmente depois que a OpenAI lançou o famoso ChatGPT. Desde então, uma onda de novas empresas surgiu com uma promessa audaciosa.

Elas afirmam ter criado ferramentas de inteligência artificial com um objetivo muito nobre: ajudar a acabar com as guerras de uma vez por todas. Mas o que exatamente são essas tecnologias e será que podemos confiar nelas em cenários tão delicados como um conflito armado? A complexidade por trás dessa promessa é muito maior do que parece à primeira vista.

IA para a paz: Genialidade ou uma grande miragem?

Quando falamos de inteligência artificial, estamos nos referindo a um universo vasto de tecnologias super avançadas. Elas são projetadas para fazer coisas que, até pouco tempo, só a inteligência humana conseguia, como resolver problemas complexos e tomar decisões. A capacidade de “aprender” com dados é o que torna essa tecnologia tão poderosa e, ao mesmo tempo, um pouco assustadora.

Esses sistemas são capazes de analisar montanhas de informações em segundos, identificando padrões que um ser humano levaria uma vida inteira para encontrar. É essa habilidade que abre portas para aplicações incríveis em áreas como medicina, finanças e, agora, na construção da paz. A ideia é usar essa capacidade de processamento para entender melhor as raízes de um conflito.

No entanto, a linha que separa a genialidade da ilusão é bastante tênue quando se trata de um assunto tão delicado. A promessa de usar a IA para mediar guerras é fascinante, mas nos obriga a questionar a verdadeira natureza dessa “inteligência”. Será que uma máquina pode realmente compreender as nuances de uma disputa humana?

O lado humano por tras da maquina

Apesar de todo o fascínio, muitos críticos fazem uma provocação interessante, dizendo que a IA “não é nem artificial nem inteligente”. Eles argumentam que por trás de cada algoritmo existe um trabalho humano monumental, desde a programação até a coleta e limpeza dos dados. Além disso, a infraestrutura necessária para manter esses sistemas funcionando consome uma quantidade gigantesca de recursos naturais.

Essa perspectiva nos lembra que a tecnologia não surge do nada, mas é um reflexo das pessoas que a criam, com todos os seus vieses e intenções. Portanto, a “inteligência” da máquina é, na verdade, um espelho da inteligência e dos valores de seus desenvolvedores. Isso se torna um ponto crítico quando a ferramenta é usada para mediar conflitos entre nações.

Ao entender que a IA é profundamente humana em sua origem, começamos a enxergar os desafios com mais clareza. A responsabilidade de garantir que essas ferramentas sejam justas e imparciais é enorme. Afinal, uma decisão errada, baseada em dados falhos ou vieses ocultos, pode ter consequências devastadoras.

Bem-vindo a era do PeaceTech: A tecnologia a servico da paz

Mesmo com todos os debates sobre sua definição, o termo “IA” se tornou o guarda-chuva para uma série de ferramentas inovadoras. Empresas do chamado “PeaceTech Lab” estão na vanguarda desse movimento, usando a tecnologia para promover a paz e a estabilidade. O objetivo é claro: combater os conflitos violentos de forma mais inteligente e eficaz.

O movimento ganhou tanto destaque que fundos de investimento específicos para iniciativas de inteligência artificial para a paz já foram criados. As próprias Nações Unidas estão abraçando essa ideia com entusiasmo, defendendo a IA como um motor de inovação. A organização vê um potencial imenso para transformar a maneira como construímos e mantemos a paz ao redor do mundo.

Essa aliança entre tecnologia e diplomacia está criando um campo completamente novo de possibilidades. A ideia de que um algoritmo pode ajudar a evitar uma guerra parece saída de um filme de ficção científica. Mas, para os pioneiros do PeaceTech, este é o futuro que eles estão construindo hoje.

O novo conselheiro dos negociadores de paz

Negociar a paz é uma das tarefas mais difíceis e complexas que existem, e os mediadores enfrentam desafios únicos a cada passo. É justamente para ajudá-los que algumas ferramentas de IA foram projetadas com um propósito muito específico. Elas funcionam como assistentes superpoderosos, capazes de processar informações de uma forma que antes era impossível.

Uma de suas principais funções é reunir e analisar dados sobre a opinião pública em zonas de conflito. Isso fornece aos negociadores percepções valiosas sobre o que as pessoas realmente pensam e sentem, informações cruciais para desenhar estratégias eficazes. A tecnologia permite ouvir milhares de vozes que, de outra forma, seriam ignoradas no processo.

Com esses dados em mãos, é possível promover um diálogo muito mais inclusivo e representativo. A IA ajuda a construir pontes, mostrando onde existem pontos de concordância e quais são as verdadeiras barreiras para a paz. Essa nova capacidade de análise pode mudar completamente o jogo das negociações internacionais.

A IA como bola de cristal: Prevendo o futuro dos conflitos

Muitas das novas ferramentas de IA são verdadeiros canivetes suíços, com múltiplas funções que vão muito além da simples análise de dados. Elas não se limitam a recomendar políticas com base no que já aconteceu. O mais impressionante é que elas também tentam prever o futuro do comportamento humano.

Isso permite que negociadores e formuladores de políticas antecipem possíveis resultados de suas ações. Imagine poder simular o impacto de um acordo de paz antes mesmo de ele ser assinado, entendendo como diferentes grupos podem reagir. É como ter uma bola de cristal baseada em dados, ajudando a tomar decisões mais informadas em situações de altíssima complexidade.

Essa capacidade preditiva é o que torna a IA uma aliada tão poderosa, mas também tão perigosa. A precisão dessas previsões é fundamental, pois um erro de cálculo pode inflamar ainda mais um conflito. O equilíbrio entre usar essa tecnologia para o bem e evitar suas armadilhas é o grande desafio do momento.

Dando voz aos silenciados: O poder da IA em zonas de conflito

Em lugares como a Líbia e o Iêmen, a ONU já está usando a inteligência artificial para uma missão muito nobre: garantir que mais pessoas possam participar das discussões políticas. Eles estão empregando ferramentas de Processamento de Linguagem Natural, ou PLN, para quebrar barreiras de comunicação. Essa tecnologia está mudando a forma como as vozes da população são ouvidas.

Mas o que exatamente é o Processamento de Linguagem Natural? Pense nele como um tradutor e organizador superinteligente, que consegue classificar, resumir e até gerar textos de forma automática. É a mesma tecnologia por trás do seu corretor ortográfico ou do ChatGPT, mas aqui ela é usada para conectar pessoas em ambientes extremamente complexos.

Essas ferramentas oferecem maneiras inovadoras de superar as divisões linguísticas e geográficas, permitindo que a opinião de cidadãos comuns chegue aos ouvidos de quem toma as decisões. É uma forma poderosa de democratizar o processo de paz, garantindo que as soluções construídas reflitam as necessidades reais da população. A tecnologia está, literalmente, dando voz a quem antes era silenciado.

Decifrando a mente coletiva com a ajuda de algoritmos

Os chamados Modelos de Linguagem de Grande Escala (LLMs, na sigla em inglês) são o cérebro por trás de muitas dessas novas iniciativas de paz. Essa tecnologia foi usada para analisar uma quantidade colossal de dados coletados de pessoas que compartilharam suas opiniões online. É como se a IA realizasse a maior pesquisa de opinião pública da história, de forma contínua.

Essas ferramentas conseguem processar milhões de comentários, postagens e mensagens, identificando tendências e sentimentos que seriam impossíveis de captar manualmente. Elas leem nas entrelinhas do que a população está dizendo, revelando medos, esperanças e prioridades. O resultado é um mapa detalhado do pensamento coletivo.

Essa análise aprofundada fornece informações valiosíssimas para os tomadores de decisão, que podem entender melhor o pulso da sociedade. Saber o que a população realmente quer é o primeiro passo para construir uma paz duradoura. Os LLMs estão se tornando uma bússola essencial para navegar nas águas turbulentas da diplomacia.

O mapa do conflito: Identificando pontos de concordancia e discordia

A ideia central de usar a inteligência artificial para construir a paz é, na verdade, bastante simples e genial. A tecnologia é usada para criar um verdadeiro mapa dos pontos de concordância e discordância entre os diferentes grupos envolvidos em um conflito. É como acender uma luz sobre o campo de batalha das ideias.

Ao identificar onde as opiniões se encontram, os mediadores ganham uma ferramenta poderosa para iniciar o diálogo. Segundo especialistas, essa estratégia é fundamental para evitar que guerras comecem ou, pior ainda, que voltem a acontecer depois de um acordo assinado. Focar no que une as pessoas, em vez de apenas no que as separa, pode ser a chave para o sucesso.

Essa abordagem transforma a negociação, tornando-a mais transparente e baseada em dados concretos. Em vez de se basear apenas na intuição, os negociadores podem usar o mapa da IA para construir pontes sólidas entre as partes. É uma nova forma de enxergar a paz, não como a ausência de guerra, mas como a construção ativa de consensos.

Akord.ai: O chatbot que quer pacificar o Sudao

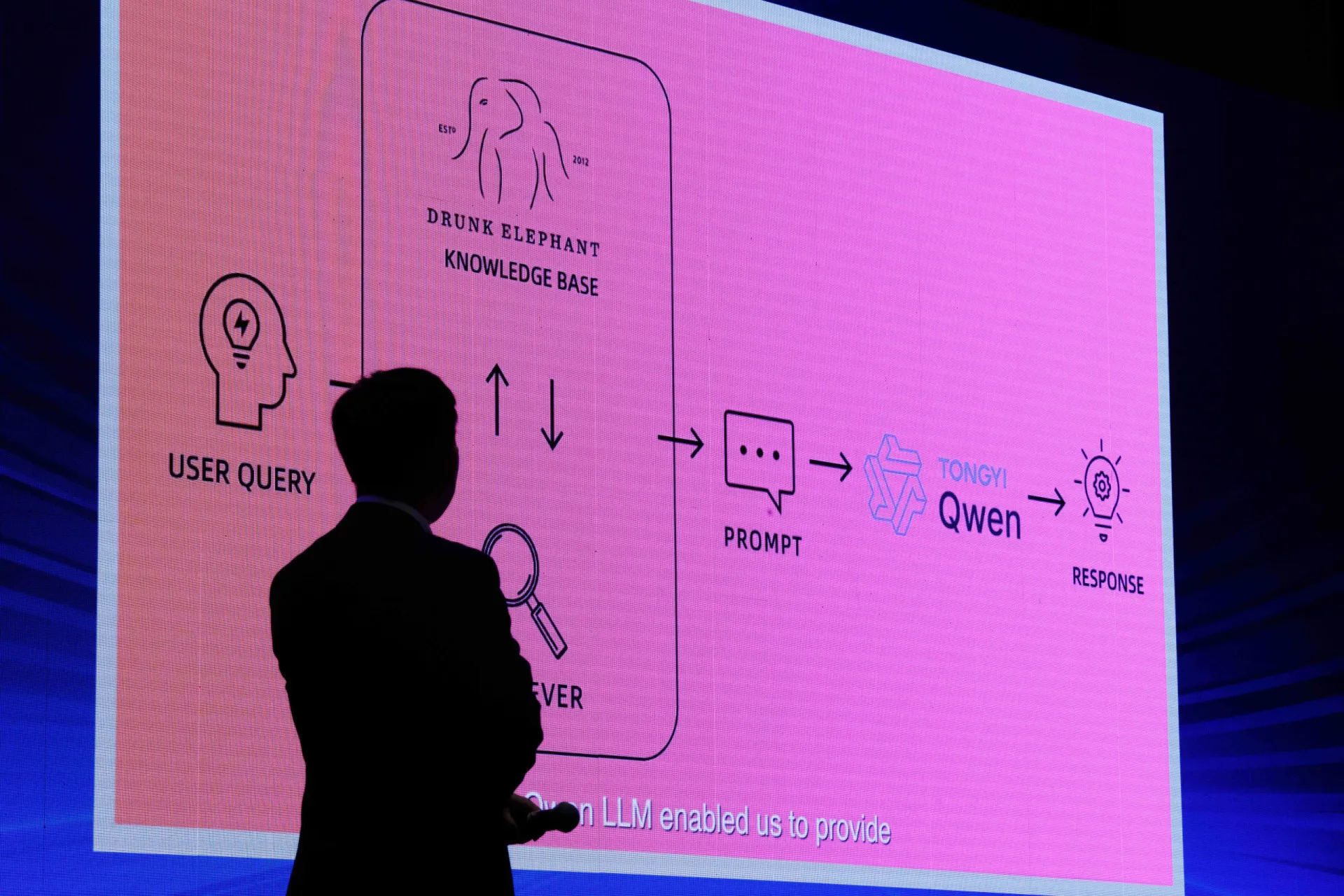

Um exemplo concreto dessa tecnologia em ação é o Akord.ai, um chatbot inovador desenvolvido pela ONG Conflict Dynamics International (CDI). Ele não é um chatbot qualquer; foi treinado com uma base de dados impressionante de 1.500 documentos focados exclusivamente no Sudão. Isso inclui acordos de paz assinados no passado e análises profundas sobre a história do país.

Este grande modelo de linguagem foi criado com um objetivo muito claro: ajudar a navegar e resolver os complexos problemas da guerra civil que assola a nação. A ferramenta funciona como um repositório de conhecimento, oferecendo insights e informações que antes estavam dispersas ou inacessíveis. É uma tentativa de usar a memória histórica para construir um futuro diferente.

O Akord.ai representa uma nova fronteira na aplicação da IA para a resolução de conflitos. Ao concentrar tanto conhecimento em uma única plataforma, ele oferece um recurso sem precedentes para mediadores, ativistas e cidadãos. A esperança é que, ao entender melhor o passado, seja possível evitar os mesmos erros no futuro.

Uma ferramenta para a nova geracao de pacificadores

Azza M. Ahmed, consultora sênior no Programa Sudão da CDI, explicou a missão principal por trás do Akord.ai. A ferramenta foi pensada para ajudar especialmente os jovens que querem se envolver ativamente na construção da paz em seu país. Muitas vezes, são eles que têm a energia e a vontade de mudar, mas lhes falta acesso à informação.

O chatbot ajuda a superar obstáculos enormes, democratizando o conhecimento sobre negociações passadas. Ele oferece um acesso rápido e fácil a lições aprendidas, estratégias que deram certo e, principalmente, as que falharam. Além disso, a ferramenta fornece dicas práticas para quem quer participar de futuras negociações.

Ao capacitar essa nova geração de pacificadores, o Akord.ai está plantando sementes para uma mudança duradoura. A ideia é que, com as informações certas em mãos, esses jovens possam liderar o caminho para um Sudão mais estável e pacífico. A tecnologia se torna, assim, um catalisador para a ação cívica.

Um conselheiro digital contra a desigualdade

Tarig Hilal, que lidera a área de inovação em IA no Akord.ai, tocou em um ponto crucial: a grande desigualdade que existe nas negociações de paz. Ele destaca que, tradicionalmente, o conhecimento e a experiência ficam concentrados nas mãos de poucas pessoas, geralmente as mais velhas e poderosas. Isso cria um desequilíbrio que pode comprometer todo o processo.

A ferramenta busca quebrar esse ciclo, nivelando o campo de jogo para todos os envolvidos. Para explicar de forma simples o que o Akord.ai faz, Hilal usou uma metáfora poderosa e muito humana. Ele disse que a IA funciona como “um consultor, um parceiro, um amigo”.

Essa visão transforma a tecnologia de algo frio e distante em um verdadeiro aliado na busca pela paz. A proposta é oferecer apoio e conhecimento a quem mais precisa, de forma acessível e imediata. É uma tentativa de usar a inteligência artificial para corrigir uma falha profundamente humana: a concentração de poder.

Acomodacao politica: A filosofia por tras do codigo

É importante entender que as recomendações dadas por uma ferramenta como o Akord.ai não são neutras. Elas estão profundamente enraizadas na visão de mundo de sua criadora, a organização Conflict Dynamics International. Essa filosofia se baseia em um conceito conhecido como “acomodação política”.

Essa abordagem para a resolução de conflitos coloca uma grande ênfase no compartilhamento de poder e no compromisso entre as partes. A ideia é que, para alcançar a paz, os grupos em disputa precisam ceder em alguns pontos para serem “acomodados” em um novo arranjo político. É uma visão pragmática que busca encontrar um meio-termo viável.

Isso significa que o chatbot não apenas fornece dados, mas também guia os usuários em direção a um tipo específico de solução. Compreender essa filosofia embutida no código é crucial para avaliar a ferramenta de forma crítica. A IA, aqui, não é apenas um espelho da realidade, mas também uma proponente de um caminho específico para a paz.

Uma estrategia controversa: Quando a solucao vira parte do problema

Apesar de alguns especialistas defenderem a ideia da acomodação política, ela está longe de ser um consenso. Na verdade, essa abordagem recebe críticas bastante severas de outros analistas. A principal preocupação é que ela pode, sem querer, acabar incentivando mais conflitos.

Jonas Horner, um especialista em negociações de paz no Sudão, oferece um argumento contundente. Ele afirma que “grupos que lutam para entrar na mesa de negociações para serem ‘acomodados’ acabaram contribuindo para o próprio conflito”. Em outras palavras, a promessa de um lugar no poder pode se tornar um incentivo para que novos grupos peguem em armas.

Essa crítica revela a enorme complexidade por trás da construção da paz. Uma estratégia que parece lógica no papel pode ter efeitos colaterais desastrosos na prática. Isso mostra que não existe uma fórmula mágica, e até mesmo as abordagens mais bem-intencionadas podem, paradoxalmente, alimentar o ciclo de violência.

A faca de dois gumes: Menos barreiras, mais riscos?

No momento, o foco do Akord.ai é reduzir as barreiras de acesso à informação, o que é um objetivo nobre e importante. No entanto, a possibilidade de usar vários chatbots como este para, de fato, elaborar os termos de um acordo de paz, levanta preocupações muito sérias. O potencial para erros com consequências graves é imenso.

O maior perigo reside nos dados usados para treinar essas ferramentas de inteligência artificial. Se os dados forem mal selecionados, incompletos ou tendenciosos, as recomendações da IA também serão. Em um contexto de negociação de paz, uma sugestão enviesada pode ter consequências trágicas e de longo alcance.

Estamos diante de uma faca de dois gumes, onde a mesma tecnologia que pode democratizar a informação também pode perpetuar injustiças. A responsabilidade de garantir a qualidade e a imparcialidade dos dados é gigantesca. É um lembrete de que, por trás de toda IA, a supervisão humana continua sendo absolutamente indispensável.

O alerta de uma especialista: A IA tambem inventa coisas

Timnit Gebru, uma das maiores especialistas em ética na IA e fundadora do Distributed AI Research Institute, fez um alerta importante sobre uma limitação crítica dos grandes modelos de linguagem. Ela explicou de forma muito direta que esses sistemas não são tão confiáveis quanto parecem. Eles são excelentes em reproduzir padrões de texto que aprenderam durante o treinamento.

O problema, segundo ela, é que eles não se limitam a reproduzir informações existentes. Gebru foi enfática ao afirmar: “LLMs produzem padrões de texto nos quais os treinamos, mas também inventam coisas”. Esse fenômeno, conhecido como “alucinação”, é um dos maiores riscos da tecnologia.

Isso significa que uma ferramenta de IA pode, simplesmente, criar fatos ou informações que não existem, mas apresentá-los com a mesma convicção de um dado verdadeiro. Em um cenário de construção de paz, onde cada palavra importa, confiar em um sistema que pode inventar informações é extremamente perigoso. O alerta de Gebru serve como um balde de água fria no otimismo tecnológico desenfreado.

O perigo da confianca cega na tecnologia

Timnit Gebru também destacou um problema psicológico muito comum entre nós, seres humanos: o “viés da automação”. Esse fenômeno descreve nossa tendência de depositar uma confiança excessiva em ferramentas automatizadas, muitas vezes sem questionar seus resultados. Acreditamos que, se veio de uma máquina, deve estar certo.

“Estudos mostram que as pessoas confiam demais nesses sistemas”, explicou Gebru, “e tomarão decisões com consequências muito sérias com base neles”. Essa confiança cega pode nos levar a cometer erros graves, especialmente quando o que está em jogo é a vida de milhares de pessoas. A máquina pode errar, e nós podemos errar ao acreditar nela incondicionalmente.

É fundamental que os usuários dessas tecnologias, sejam eles negociadores, ativistas ou cidadãos, mantenham sempre um senso crítico. A IA deve ser vista como uma ferramenta de apoio, um ponto de partida para a análise, e não como um oráculo infalível. Desconfiar da máquina é, ironicamente, a forma mais inteligente de usá-la.

Projeto Didi: Cacando o momento perfeito para a paz

Outra frente fascinante no uso da IA para a paz envolve o timing das negociações. Grandes modelos de linguagem estão sendo cada vez mais usados para tentar identificar o momento ideal para propor um acordo. Um exemplo disso é o Projeto Didi, uma startup israelense que está inovando nesse campo.

O objetivo do projeto é identificar os chamados “momentos de maturidade” em um conflito. Essas são janelas de oportunidade raras em que um acordo de paz, que antes era inaceitável, de repente pode parecer mais palatável para ambas as partes. Isso pode acontecer mesmo que os termos do acordo tenham mudado muito pouco.

A startup acredita que a IA pode “sentir” quando essa mudança sutil no clima político está acontecendo. Ao analisar a linguagem usada na mídia e no debate público, o sistema busca sinais de que a receptividade para a paz está aumentando. É uma tentativa de aplicar a ciência de dados à arte da diplomacia.

A licao da Irlanda do Norte: Um modelo para o futuro?

Para construir seu modelo de inteligência artificial, o Projeto Didi olhou para um dos casos de sucesso mais emblemáticos da história recente. O LLM foi treinado intensivamente com os padrões linguísticos do período que antecedeu o Acordo da Sexta-feira Santa. Esse acordo histórico conseguiu reduzir drasticamente o conflito ativo na Irlanda do Norte há mais de 25 anos.

Ao aprender com esse caso, a IA busca identificar um padrão replicável em outros conflitos. A análise de milhares de artigos de jornais, discursos e documentos daquela época serve como uma espécie de “DNA da paz”. O sistema tenta encontrar marcadores linguísticos que sinalizaram a aproximação do “momento de maturidade”.

Essa estrutura histórica fornece uma base sólida para os esforços da startup em prever quando um acordo tem mais chances de ser aceito. É uma forma de usar as lições do passado para iluminar o caminho em direção à paz no presente. A esperança é que o que funcionou na Irlanda do Norte possa oferecer pistas para outros lugares do mundo.

Do passado ao presente: A IA na linha de frente do conflito em Gaza

Shawn Guttman, o CEO e fundador do Projeto Didi, e sua equipe estão agora aplicando seu modelo a um dos conflitos mais complexos e urgentes da atualidade. Eles estão adaptando a tecnologia para ser usada no contexto da guerra de Israel em Gaza. A missão é tentar encontrar sinais de esperança em meio a um cenário devastador.

Para isso, o projeto está reunindo uma vasta quantidade de dados de veículos de notícias tanto israelenses quanto palestinos. Usando técnicas de aprendizado de máquina, a plataforma analisa as mudanças no sentimento público em relação à paz. A IA busca captar nuances na forma como as pessoas falam sobre o conflito e suas possíveis soluções.

Essa aplicação em tempo real coloca a tecnologia na linha de frente da diplomacia moderna. A análise constante do discurso público pode revelar janelas de oportunidade que seriam invisíveis a olho nu. É uma tentativa ousada de usar a IA para encontrar um caminho em direção ao diálogo, mesmo nas circunstâncias mais difíceis.

Momentos de maturidade ou de exaustao? A critica ao metodo

Assim como a “acomodação política”, o conceito de “momentos de maturidade” também não está livre de críticas. Especialistas em resolução de conflitos apontam para um lado sombrio dessa teoria. Eles argumentam que esses momentos frequentemente coincidem com um estado de completa exaustão da população local.

Nesse cenário, a paz não é alcançada por um desejo genuíno de reconciliação, mas simplesmente porque as pessoas não aguentam mais sofrer. Os acordos de paz firmados nessas condições, muitas vezes, falham em abordar as causas profundas da violência. Eles acabam sendo apenas um curativo temporário em uma ferida que continua aberta.

Essa crítica nos lembra que a paz não pode ser apenas a ausência de guerra, mas deve ser a presença de justiça. Um acordo nascido do desespero pode não ser sustentável a longo prazo. Isso levanta questões importantes sobre o tipo de paz que a IA está sendo programada para buscar.

Nao apenas prever, mas criar a paz

Shawn Guttman, do Projeto Didi, tem uma visão ambiciosa para o futuro de sua ferramenta. Ele não quer que a IA seja apenas um observador passivo, que identifica momentos de maturidade quando eles surgem. O objetivo é transformar o projeto em uma ferramenta proativa, que ajude a criar esses momentos.

Como isso seria possível? A ideia é equipar os ativistas da paz com informações detalhadas sobre o impacto de suas ações. A IA poderia mostrar se as campanhas e mensagens estão, de fato, influenciando “corações e mentes humanas” na direção da paz.

Isso transformaria a plataforma em um guia estratégico para quem trabalha no terreno. Os ativistas poderiam ajustar suas abordagens em tempo real, com base em dados concretos sobre o que está funcionando. É uma mudança de paradigma: em vez de apenas esperar pela paz, a tecnologia ajudaria a construí-la ativamente.

A maquina consegue sentir? Os limites da empatia artificial

Uma das maiores limitações da inteligência artificial reside em sua incapacidade de verdadeiramente compreender as emoções humanas. Evidências científicas sugerem que os grandes modelos de linguagem (LLMs) têm muita dificuldade para interpretar sentimentos com precisão. Isso acontece porque nós, humanos, expressamos nossas emoções de maneiras sutis, complexas e, muitas vezes, ambíguas.

Não é surpresa que os LLMs se destaquem na decodificação de informações claras e estruturadas, como as linguagens de programação. Nesses casos, não há espaço para ambiguidade, e cada comando tem um significado preciso. Com as emoções humanas, a história é completamente diferente.

Essa dificuldade em “ler” sentimentos é um obstáculo gigantesco para uma IA que pretende mediar conflitos. Afinal, guerras são movidas por emoções profundas como medo, raiva, orgulho e esperança. Uma máquina que não consegue entender essas nuances pode acabar cometendo erros graves de interpretação.

A etica em xeque: E correto uma maquina ‘ler’ emocoes?

A especialista Timnit Gebru vai além e critica duramente as alegações de que LLMs e algoritmos de PLN podem interpretar pensamentos ou emoções humanas. Ela destacou que mesmo que um sistema consiga detectar com precisão certos marcadores emocionais, como uma mudança no tom de voz, isso não significa que ele entenda o estado emocional de alguém. A correlação não implica compreensão.

Mas a questão que Gebru levanta é ainda mais profunda e nos leva a um dilema ético. Ela argumenta que, mesmo se essa tecnologia fosse possível e 100% precisa, seu uso levantaria profundas preocupações éticas. Ter uma máquina capaz de “ler” nossos sentimentos mais íntimos abre portas para manipulação e controle em uma escala sem precedentes.

O debate, portanto, não é apenas sobre a precisão técnica, mas sobre o tipo de sociedade que queremos construir. Permitir que governos ou empresas usem IA para vigiar nossas emoções é um passo perigoso em direção a um futuro distópico. A privacidade dos nossos sentimentos talvez seja a última fronteira a ser defendida.

A tentacao das solucoes faceis para problemas complexos

Os próprios desenvolvedores de IA frequentemente fazem questão de ressaltar que suas ferramentas não são infalíveis. Eles alertam que essas tecnologias não devem ser vistas como soluções universais ou mágicas para todos os problemas. No entanto, a realidade do mercado muitas vezes conta uma história diferente.

Esses produtos acabam capitalizando o enorme entusiasmo do público pela inteligência artificial. Eles são frequentemente apresentados como soluções simples e com um verniz científico para questões políticas que são, na verdade, profundamente complexas e intrincadas. A promessa de uma “solução tecnológica” é muito sedutora.

Essa simplificação excessiva é perigosa, pois pode nos levar a ignorar as verdadeiras causas de um conflito, que são quase sempre humanas e políticas. A tecnologia pode ser uma ferramenta útil, mas a crença de que ela pode resolver tudo sozinha é uma ilusão perigosa. A paz não pode ser terceirizada para um algoritmo.

Uma ferramenta de apoio, nao uma varinha de condao

Embora os problemas políticos frequentemente apresentem desafios técnicos nos quais a IA pode, de fato, ajudar, não podemos nos esquecer do essencial. As verdadeiras causas da guerra estão enraizadas na dinâmica de poder e nas lutas políticas entre seres humanos. Nenhum algoritmo pode, sozinho, resolver essas questões.

Para que a inteligência artificial possa desempenhar um papel significativo e positivo na construção da paz, ela precisa ser desenvolvida de forma ética e transparente. Seu propósito deve ser servir como um complemento, um suplemento aos esforços humanos e políticos, e nunca como um substituto. A decisão final deve sempre permanecer nas mãos das pessoas.

A tecnologia pode fornecer dados, análises e novas perspectivas, mas a sabedoria, a empatia e a coragem necessárias para fazer a paz são qualidades exclusivamente humanas. Usar a IA como uma ferramenta de apoio, e não como uma varinha de condão, é o único caminho sensato a seguir. A colaboração entre a inteligência humana e a artificial é onde reside o verdadeiro potencial.

Os verdadeiros superpoderes da IA na paz

Apesar de todos os riscos, os especialistas reconhecem o imenso potencial de ferramentas como o Akord.ai. Elas podem, de fato, melhorar o acesso à informação e promover uma maior inclusão nos processos de paz, o que já é uma grande vitória. Democratizar o conhecimento é um passo fundamental para negociações mais justas.

Da mesma forma, plataformas de análise de mídia como o Projeto Didi oferecem compreensões valiosas que antes eram inalcançáveis. Elas podem ajudar a otimizar as estratégias de comunicação dos ativistas da paz. Além disso, fornecem pistas importantes sobre o momento ideal para avançar com as negociações.

Esses são os verdadeiros “superpoderes” da IA no contexto da paz: ampliar vozes, organizar informações e oferecer insights estratégicos. Quando usada com sabedoria e senso crítico, a tecnologia pode se tornar uma aliada poderosa. O segredo é focar em suas fortalezas e estar sempre ciente de suas limitações.

A voz da experiencia: As preocupacoes dos especialistas

As preocupações com o uso da IA na construção da paz não vêm apenas de um lado; elas unem tanto cientistas da computação quanto negociadores de conflitos. Ambos os grupos expressam um receio comum sobre as suposições e os vieses que estão sendo incorporados nos grandes modelos de linguagem. Eles alertam que o que está “debaixo do capô” da tecnologia é tão importante quanto o que ela mostra na superfície.

Esses especialistas alertam para não nos deixarmos levar pelo brilho da tecnologia, lembrando-nos constantemente de suas limitações inerentes. Há um perigo real em revisitar abordagens para a paz que já se mostraram malsucedidas no passado. Se a IA for treinada com dados de estratégias que falharam, ela pode simplesmente nos levar a repetir os mesmos erros.

A complexidade da paz exige mais do que apenas processamento de dados; exige sabedoria, contexto e compreensão cultural. A voz da experiência, tanto dos tecnólogos quanto dos diplomatas, é um coro uníssono que pede cautela. Ignorar esses avisos seria, no mínimo, imprudente.

Um mundo em chamas e o peso da responsabilidade tecnologica

Os perigos representados pelas tecnologias preditivas e pelos sistemas de IA que recomendam soluções são ainda mais críticos no contexto atual. Vivemos em um mundo com 56 conflitos armados em andamento, o maior número registrado desde a Segunda Guerra Mundial. A paz nunca foi um bem tão precioso e tão ameaçado.

Neste cenário, as consequências de suposições falhas ou de erros nos algoritmos são dramaticamente ampliadas. Uma recomendação errada não é apenas um erro técnico; pode custar vidas e prolongar o sofrimento de milhões de pessoas. A margem para erro é praticamente zero.

Isso coloca um peso enorme de responsabilidade sobre os ombros dos desenvolvedores e usuários dessas tecnologias. A promessa de usar a IA para a paz é nobre, mas o caminho é cheio de armadilhas. Navegar por ele exigirá uma combinação sem precedentes de inovação tecnológica, rigor ético e, acima de tudo, humildade humana.